24个Transformer模型高效魔改变体盘点,无bug拿来即用_transformer …

Jan 24, 2024 · 通过重新排序子层来改进Transformer 论文:Improving Transformer Models by Reordering their Sublayers. 「简介:」论文研究了Transformer网络中子层的不同排序对性能的 …

LLM(廿四):Transformer 的结构改进与替代方案 - 知乎

Transformer 结构的训练和推理效率如何,如何平衡效果和效率? 是否存在 Transformer 之外的新结构可以以更低的成本,达到同等或更高的效果? 希望通过以上问题的思考和讨论,能够帮 …

Transformer中的各种改进 - 知乎 - 知乎专栏

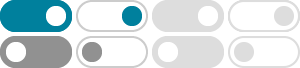

LLM大行其道的时代,Transformer成为了当下最流行的模型结构,没有之一。为了达到加速或提效的目的,在 vanilla Transformer 的基础上,业界探索了针对不同组件的各种改进。 一、 Self …

Transformer的七十二变!12种魔改的Transformer模型大分享_魔改transformer …

Dec 19, 2024 · 但正如所有科技的进化,Transformer也在不断地被“魔改”以适应更复杂的任务和挑战。下面我们探讨了几种令人印象深刻的Transformer模型变体,它们通过创新的技术改进, …

14篇最新Transformer热门论文!涵盖注意力机制、架构改进、适 …

今天,特意为大家整理了14篇Transformer热门论文,这些论文涵盖了注意力机制、架构改进以及适用性扩展等多个方向,一起看看Transformer方向近期的研究成果和进展吧!

计算机视觉中的transformer模型创新思路总结 - 知乎

Dec 5, 2021 · 前言本文回顾了ViT的结构,总结了计算机视觉中的transformer的主要改进思路:改进分块,改进位置编码,改进Encoder,增加Decoder。每个思路下都介绍了相关的论文,介 …

近期关于Transformer结构有潜力的改进方法总结 - CSDN博客

May 21, 2023 · 以下总结了几个较受关注及个人认为比较有潜力的改进,帮助快速了解,同时推荐大家仔细研读原论文。 1 Gated Linear Unit (GLU) 论文:GLU Variants Improve …

有哪些令你印象深刻的魔改transformer? - 知乎

性能相较普通transformer有若干提升,速度略有下降。 给后续的文章提供了很多改进的机会:相对位置可以看做词与词之间的一种relation,而相对位置编码套在图网络

25个Transformer模型高效魔改变体盘点,无bug拿来即用

Nov 19, 2024 · 「简介:」论文介绍了三种改进Transformer模型训练的方法。 第一种是使用预规范化残差连接,可以不用预热直接用大学习率训练。 第二种是用一个参数进行ℓ2规范化,这样 …

Transformer模型有多少种变体?复旦邱锡鹏教授团队做了全面综 …

Mar 29, 2023 · 改进的方法包括轻量级 attention(例如稀疏 attention 变体)和分而治之的方法(例如循环和分层机制); 模型泛化。由于 Transformer 是一种灵活的架构,并且对输入数据的 …

- Some results have been removed